- Starten Sie Windows PowerShell als Administrator.

- Installieren Sie den Windows-NFS-Client:

- Konfigurieren Sie eine Zuordnung von Windows-Benutzern zu Unix-UIDs und -GIDs gemäß den Richtlinien Ihres Unternehmens:

- NFS-Client neu starten:

Einrichten einer Datenbankverbindung

Stellen Sie vor Beginn sicher, dass das Befehlszeilentool kubectl installiert ist und dass eine Verbindung zum Kubernetes-Cluster hergestellt wurde.

- Rufen Sie die Consul-Weboberfläche mit dem folgenden Befehl auf:

http://localhost:8500/ui/dc1/kv/secret/.

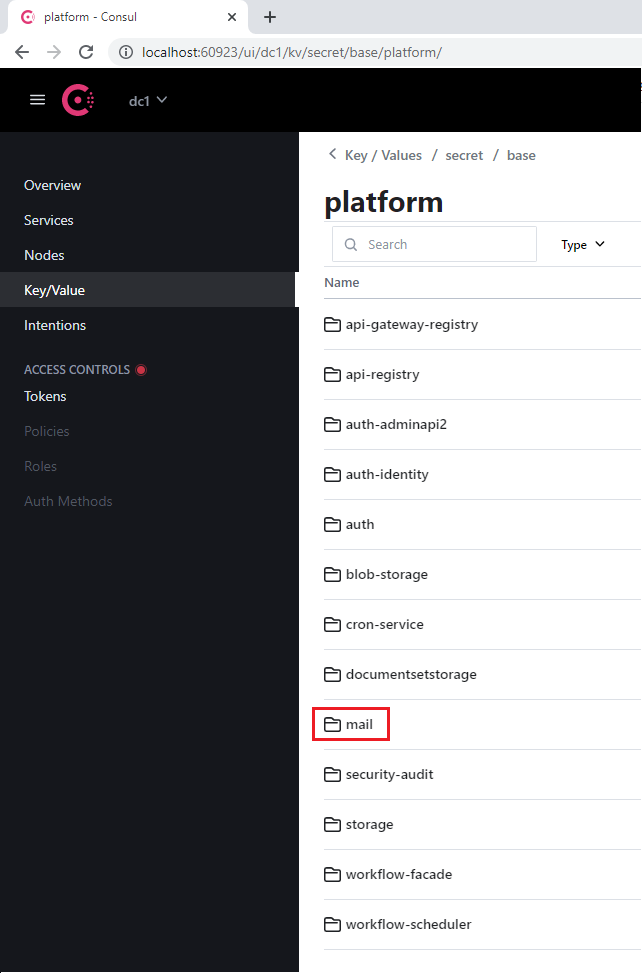

- Verwenden Sie die Registerkarte Key/Value, die sich öffnet, um die richtige Vantage-Umgebung auszuwählen.

- Wählen Sie entweder das Projekt platform oder vantage sowie den entsprechenden Dienst, der die Datenbank verwendet (zum Beispiel „mail“).

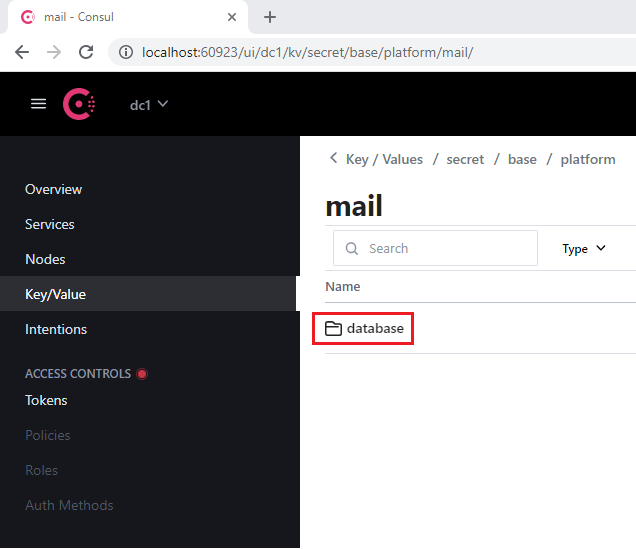

- Navigieren Sie zum Abschnitt database, den jeder Dienst enthält.

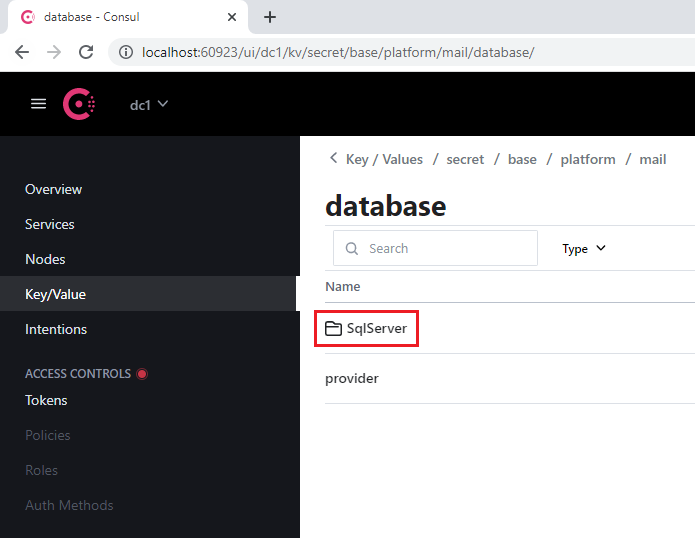

- Öffnen Sie den Abschnitt SqlServer.

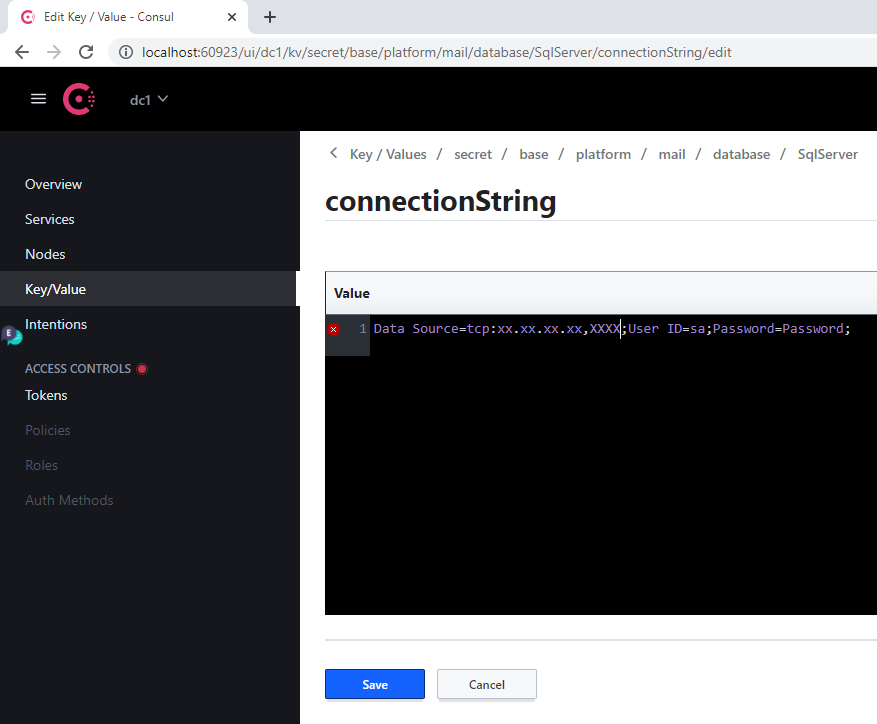

- Unter dem Schlüssel connectionString:

- Ersetzen Sie den alten Wert von Server durch die Adresse des neuen Servers

- Geben Sie die neue Datenbank im Parameter Database an

- Geben Sie die Anmeldedaten in den Parametern User Id und Password an

- Klicken Sie auf Save.

- Starten Sie den geänderten Dienst neu, indem Sie den folgenden Befehl ausführen:

Wenn sich die Serveradresse ändert, muss dieses Verfahren für jede Datenbank ausgeführt werden.

Referenz zu Datenbankdiensten

Platform Services

| Consul-Abschnittsname | Service-Bezeichnung | Hinweise |

|---|---|---|

| api-gateway-registry | api-gateway-registry | |

| api-registry | api-registry | |

| auth-adminapi2 | auth-adminapi2 | |

| auth-identity | auth-identity | |

| auth | auth-sts-identity, auth-adminapi2 | Diese Datenbank wird von zwei Services verwendet |

| blob-storage | blob-storage | |

| cron-service | cron-service | |

| documentsetstorage | documentsetstorage | |

| security-audit | security-audit | |

| storage | storage | Der Datenbankabschnitt wird im fileMetadata-Datenkatalog gespeichert |

| workflow-facade | workflow-facade | |

| workflow-scheduler | workflow-scheduler |

Vantage-Dienste

| Consul-Abschnittsname | Dienstbezeichnung |

|---|---|

| catalogstorage | catalogstorage |

| folderimport | folderimport |

| interactive-jobs | interactive-jobs |

| mailimport | mailimport |

| permissions | permissions |

| publicapi | publicapi |

| reporting | reporting |

| secretstorage | secretstorage |

| skill-monitor | skill-monitor |

| skillinfo | skillinfo |

| subscriptions | subscriptions |

| tokenmanagement | tokenmanagement |

| transactions | transactions |

| workspace | workspace |

Einrichten der GPU

Systemanforderungen für GPU

- Mindestens 12 GB virtueller GPU-Speicher

- 1 CPU und 4 GB RAM für jede virtuelle GPU auf dem Host (z. B. muss eine VM mit einer einzelnen virtuellen GPU mit 12 GB mindestens 2 CPUs und 8 GB RAM haben)

Virtuelle GPU

- Kopieren Sie das NVIDIA GRID-Treiberpaket aus dem NVIDIA Application Hub auf eine virtuelle Maschine mit einer GPU und führen Sie die folgenden Befehle aus:

-

Installieren Sie den nVidia GPU Operator im Kubernetes-Cluster:

a. Legen Sie die Lizenz-Token-Datei (im nVidia Application Hub generiert) im Ordner

$PWD/gpu/ab, bevor Sie den Vantage-Installer-Container starten. b. Fügen Sie den Parameter-v $PWD/gpu:/ansible/files/gpu:rozu dem Befehl hinzu, mit dem der Vantage-Installer-Container gestartet wird:

[abbyy_workers] hinzu. Der Name der virtuellen Maschine mit der GPU muss „gpu“ enthalten:

- Richten Sie vGPU ein, indem Sie das folgende Playbook ausführen:

GPU-Passthrough

- Führen Sie den Vantage-Installer-Container aus:

- Fügen Sie einen GPU-Knoten (z. B. worker2-12-a40-gpu01) zur Inventory-Datei in der Gruppe

[abbyy_workers]hinzu:

- Führen Sie das Playbook aus:

- Installieren Sie das Helm-Chart für den GPU Operator:

- Fügen Sie dem Knoten einen Taint hinzu:

Testen und Bereitstellen der GPU

- Führen Sie diesen Befehl aus:

- Erstellen Sie eine YAML-Datei mit folgendem Inhalt und wenden Sie diese an:

- Prüfen Sie das Pod-Protokoll. Sie sollten eine Antwort sehen, die

Test PASSEDenthält:

- Fügen Sie die folgenden Parameter zur Datei

env_specific.ymlhinzu:

- Führen Sie einen der folgenden Schritte aus:

- Wenn Vantage bereits installiert ist, führen Sie das folgende Playbook aus, um GPU-Worker bereitzustellen:

- Wenn Vantage noch nicht installiert wurde, werden GPU-Worker während der Installation mit bereitgestellt.

Einrichten eines Inaktivitäts-Timeouts für die Manuelle Überprüfung

- Greifen Sie auf die Consul-Weboberfläche zu, indem Sie Folgendes ausführen:

http://localhost:8500/ui/dc1/kv/secret/.

- Verwenden Sie die Registerkarte Key/Value, um die richtige Vantage-Umgebung auszuwählen.

- Ändern Sie die Werte der folgenden Schlüssel:

| Key | Description |

|---|---|

secret/abbyy-vantage/vantage/verification/interactiveJobsOptions/popTimeout | Die Mindestdauer der Inaktivität eines Benutzers, bevor eine Aufgabe in die Warteschlange für interaktive Aufgaben zurückgegeben wird. Jede interaktive Aktion (Mausbewegung, Tastatureingabe, Patchverarbeitung usw.) setzt den Countdown zurück. Standardwert: 00:15:00 (15 Minuten) |

secret/abbyy-vantage/vantage/verification/interactiveJobsOptions/processingPopTimeout | Die Mindestdauer der Benutzerinaktivität, nach der die Aufgabe wieder in die Warteschlange gestellt wird, wenn lang andauernde Vorgänge ausgeführt werden (Anwenden eines Skills, Blättern durch Seiten usw.). Wenn ein lang andauernder Vorgang startet, wird dieser Wert auf die maximal zulässige Inaktivitätsdauer gesetzt. Wenn der Vorgang abgeschlossen ist, wird die Inaktivitätsdauer auf den popTimeout-Wert zurückgesetzt. Standardwert: 1.00:00:00 (24 Stunden) |

- Klicken Sie auf Save.

- Starten Sie die Dienste verification und manualverification neu:

Aktualisieren des SSL-Zertifikats

Lens verwenden

- Gehen Sie zu Config > Secrets und suchen Sie alle Secrets mit der Bezeichnung

platform-wildcard. - Suchen Sie für jedes Secret den Abschnitt Data, klicken Sie auf das Show-Symbol und aktualisieren Sie die Werte:

- Geben Sie den Wert des neuen Zertifikats in das Feld

tls.crtein - Geben Sie den Wert des zugehörigen Schlüssels in das Feld

tls.keyein

- Geben Sie den Wert des neuen Zertifikats in das Feld

Das Zertifikat und der Schlüssel müssen PEM-Dateien mit in Base64-ASCII codiertem Inhalt (PKCS#8) sein. Für das Zertifikat sollten sie mit

-----BEGIN CERTIFICATE----- und für den Schlüssel mit -----BEGIN PRIVATE KEY----- beginnen.- Klicken Sie auf Save.

Verwenden der Linux-Befehlszeile

- Stellen Sie sicher, dass Sie Zugriff auf den Kubernetes-Cluster haben:

- Platzieren Sie das Zertifikat und den Schlüssel im PEM-Format in das aktuelle Verzeichnis:

cert.pem,key.pem.

- Führen Sie die folgenden Befehle aus: