Als Systemadministrator sind Sie dafür verantwortlich, ABBYY Vantage jederzeit zu überwachen und zu verwalten sowie alle Fehler zu erkennen, die während der Dokumentenverarbeitung auftreten können, einschließlich ihrer Ursachen.

Sie können ABBYY Vantage auf folgende Weise überwachen:

- Vantage-Protokolldateien

- Den integrierten Skill Monitor-Service, der Statistiken für vorhandene Vantage-Skills sammelt und detaillierte Informationen zu abgeschlossenen und laufenden Vorgängen bereitstellt. Mit diesem Service können Sie außerdem Vorgangsereignisinformationen abrufen, die für den technischen Support erforderlich sind.

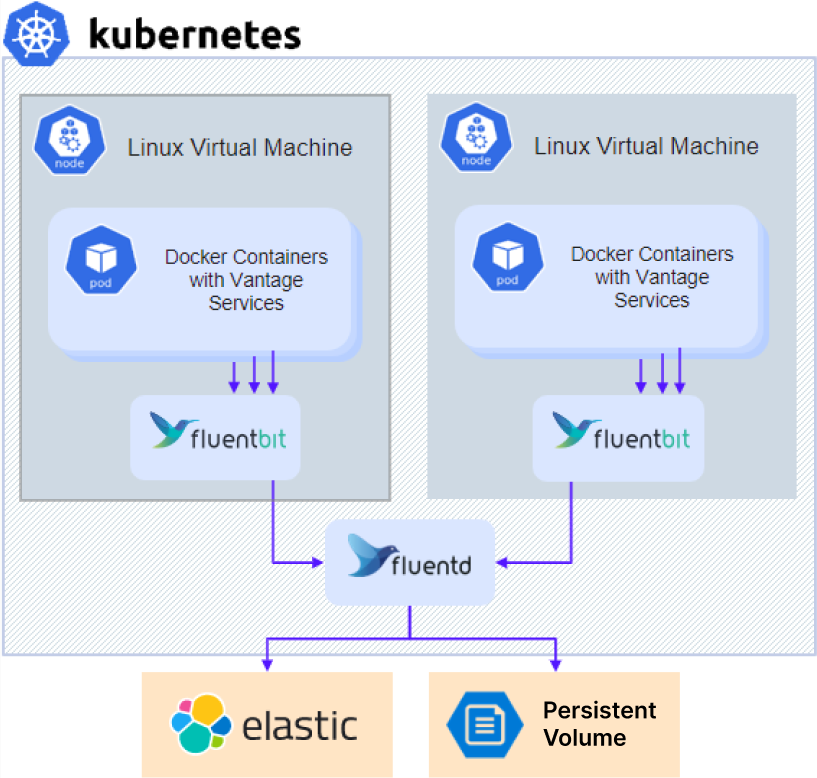

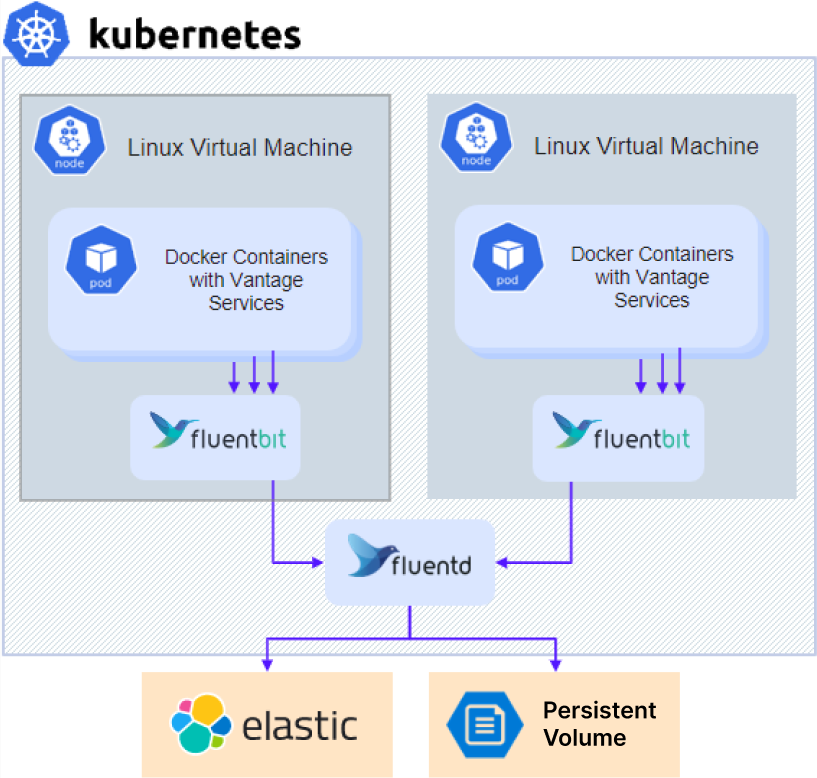

- Drittanbieterdienste, mit denen Sie interne Vantage-Prozesse und bestimmte Workflows überwachen, die gesammelten Daten analysieren, um die Dokumentenverarbeitung weiter abzustimmen und zu optimieren, sowie Protokolle erfassen und auswerten können.

Wenn Sie den technischen Support kontaktieren, können Sie zusätzlich zu den Fehlerinformationen auch die Version des Produkts und seiner Komponenten angeben, indem Sie Folgendes tun:

- Klicken Sie im linken Bereich auf Help, dann auf About und wählen Sie Version details.

- Kopieren Sie diese Informationen.

So greifen Sie auf Diagnoseprotokolle zu

So greifen Sie auf Diagnoseprotokolle zu:

So greifen Sie auf Diagnoseprotokolle zu:

- Wenn Sie einen externen NFS-Server oder einen anderen externen Speicher verwenden, fahren Sie direkt mit Schritt 3 fort.

- Bei einer Installation mit einem In-Cluster-NFS-Server (Standard für die Konfiguration Ohne Hochverfügbarkeit) ermitteln Sie die IP-Adresse des NFS-Servers:

kubectl -n nfs get po -lapp.kubernetes.io/name=nfs-kernel-server -o jsonpath='{ .items[*].status.hostIP }'

- Greifen Sie auf die Freigabe zu:

- Für NFS:

- Linux:

mount –t nfs <nfs server ip>:/ /opt/mount

- Windows: Installieren Sie ClientForNFS, öffnen Sie den Explorer und wechseln Sie zu

\\<nfs server ip>

- Für andere Arten von externem Speicher: Wenden Sie sich an Ihren Systemadministrator, um Anweisungen zum Zugriff zu erhalten.

- Navigieren Sie zum Verzeichnis

\\<nfs server ip>\<sharename>\<env>\abbyy-monitoring\fluentd-pvc.

Bereitstellung von Protokollen für den technischen Support

- Navigieren Sie zum Ordner mit den Protokollen. Protokolle werden in Unterordnern gespeichert, die denselben Namen wie die Namespaces des Kubernetes-Clusters tragen. Vantage-Protokolle befinden sich im Ordner

abbyy-vantage.

- Kopieren Sie die Dateien, die sich auf den Zeitraum beziehen, in dem das Problem aufgetreten ist. Die Protokolle liegen als gzip-komprimierte Dateien mit Dateinamen im Format

Y-M-DD-H vor (z. B. 2022-12-09-0800.log.gz).

- Senden Sie die Dateien an den technischen Support von ABBYY.

Elasticsearch und Kibana sind Tools zum Suchen, Analysieren und Visualisieren von Logs. Elasticsearch und Kibana werden nicht zusammen mit ABBYY Vantage installiert und müssen separat installiert und eingerichtet werden. Dies kann unabhängig davon erfolgen, ob das Produkt installiert ist oder nicht. Sie können auch eine bereits vorhandene Installation verwenden.

Das folgende Einrichtungsbeispiel wurde vereinfacht und dient nur als Beispiel.

- Klonen Sie das Repository:

git clone https://github.com/elastic/cloud-on-k8s.git

cd cloud-on-k8s

git checkout 2.5

cd deploy/eck-operator

- Installieren Sie den Operator zur Bereitstellung der Ressourcen:

helm -n elastic upgrade -i eck-operator . --create-namespace

- Erstellen Sie eine Datei namens

elastic.yaml mit folgendem Inhalt:

apiVersion: elasticsearch.k8s.elastic.co/v1

kind: Elasticsearch

metadata:

name: elasticsearch

namespace: elastic

spec:

version: 8.5.1

nodeSets:

- config:

indices.fielddata.cache.size: 38%

xpack.ml.enabled: false

xpack.security.enabled: true

count: 1

name: default

podTemplate:

spec:

containers:

- name: elasticsearch

resources:

limits:

memory: 1Gi

cpu: '1'

requests:

cpu: '1'

memory: 1Gi

initContainers:

- command:

- sh

- '-c'

- sysctl -w vm.max_map_count=262144

name: sysctl

securityContext:

privileged: true

runAsUser: 0

nodeSelector:

kubernetes.io/os: linux

volumeClaimTemplates:

- metadata:

name: elasticsearch-data

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 128Gi

- Erstellen Sie eine Datei mit dem Namen

kibana.yaml mit folgendem Inhalt:

apiVersion: kibana.k8s.elastic.co/v1

kind: Kibana

metadata:

name: kibana

namespace: elastic

spec:

version: 8.5.1

count: 1

elasticsearchRef:

name: elasticsearch

podTemplate:

spec:

containers:

- name: kibana

env:

- name: NODE_OPTIONS

value: "--max-old-space-size=2048"

resources:

requests:

memory: 512Mi

cpu: 0.5

limits:

memory: 1Gi

cpu: 1

nodeSelector:

kubernetes.io/os: linux

- Führen Sie den folgenden Befehl aus, um Elasticsearch zu installieren:

kubectl -n elastic apply -f elastic.yaml

kubectl -n elastic get statefulset

- Führen Sie den folgenden Befehl aus, um Kibana zu installieren:

kubectl -n elastic apply -f kibana.yaml

kubectl -n elastic get deployment

- Rufen Sie das Passwort für einen Elasticsearch-Benutzer ab:

kubectl -n elastic get secret elasticsearch-es-elastic-user -o go-template='{{.data.elastic | base64decode }}'

- Fügen Sie Ihrer Datei

env_specific.yaml die folgenden Parameter hinzu:

logging:

enabled: true

elasticsearch:

enabled: true

host: elasticsearch-es-http.elastic.svc.cluster.local

username: elastic

password: elastic_user_password

scheme: https

- Wenn Sie Kibana nachträglich installieren, nachdem das Produkt bereits installiert wurde, aktualisieren Sie Ihre Datei

env_specific.yaml und führen Sie den folgenden Befehl aus:

ansible-playbook -i inventories/k8s playbooks/6-DeployMonitoring-k8s.yml

Grafana muss im Cluster installiert werden, da Prometheus nur innerhalb eines Clusters verfügbar ist.

Das folgende Einrichtungsbeispiel wurde vereinfacht und dient nur zur Veranschaulichung.

- Erstellen Sie eine Datei mit dem Namen

grafana.yaml.

- Kopieren Sie den folgenden Code in die Datei und speichern Sie sie:

persistence:

enabled: false

rbac:

create: true

namespaced: false

serviceAccount:

create: true

podLabels:

app.kubernetes.io/component: grafana

nodeSelector:

kubernetes.io/os: linux

adminUser: admin

adminPassword: password

plugins:

- grafana-piechart-panel

- flant-statusmap-panel

grafana.ini:

server:

root_url: "%(protocol)s://%(domain)s:%(http_port)s/grafana/"

enable_gzip: "true"

ingress:

enabled: true

annotations:

kubernetes.io/ingress.class: abbyy-nginx

nginx.ingress.kubernetes.io/rewrite-target: /$2

tls:

- secretName: platform-wildcard

hosts:

- {{ env }}.{{ domain }}

hosts:

- {{ env }}.{{ domain }}

path: "/grafana(/|$)(.*)"

sidecar:

dashboards:

enabled: true

label: grafana_dashboard

datasources:

datasources.yaml:

apiVersion: 1

datasources:

- name: Prometheus

editable: true

isDefault: true

jsonData:

timeInterval: 5s

tlsSkipVerify: true

type: prometheus

url: 'http://prometheus-scaling.abbyy-monitoring.svc.cluster.local:9090'

- editable: true

isDefault: true

jsonData:

timeInterval: 5s

tlsSkipVerify: true

name: Victoria

type: prometheus

url: 'http://victoria-metrics-abbyy.abbyy-monitoring.svc.cluster.local:8428'

Ersetzen Sie den Wert des Parameters host durch den Domainnamen Ihres Vantage-Clusters, und ändern Sie das anfängliche Administratorpasswort.

- Führen Sie die folgenden Befehle aus:

helm repo add grafana https://grafana.github.io/helm-charts

helm -n abbyy-monitoring upgrade -i grafana grafana/grafana -f grafana.yaml