- Ejecute Windows PowerShell como Administrador.

- Instale el cliente NFS de Windows:

- Configure una asignación de usuarios de Windows a UID y GID de Unix según las políticas de su empresa:

- Reiniciar el cliente NFS:

Configuración de una conexión de base de datos

Antes de comenzar, asegúrese de que la herramienta de línea de comandos kubectl esté instalada y de que se haya establecido una conexión con el clúster de Kubernetes.

- Acceda a la interfaz web de Consul ejecutando el siguiente comando:

http://localhost:8500/ui/dc1/kv/secret/.

- Utilice la pestaña Key/Value que se abrirá para seleccionar el entorno de Vantage correcto.

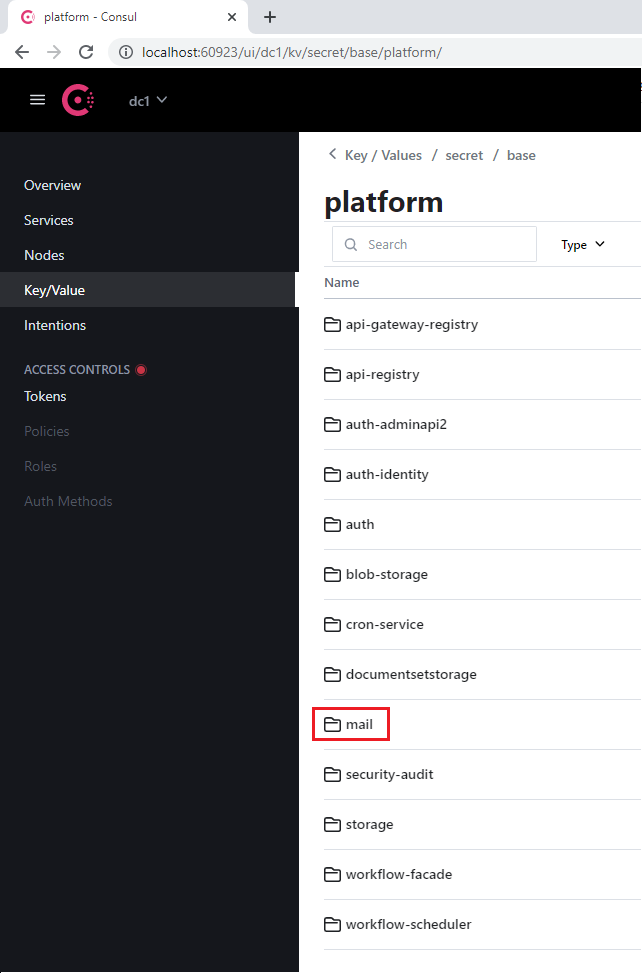

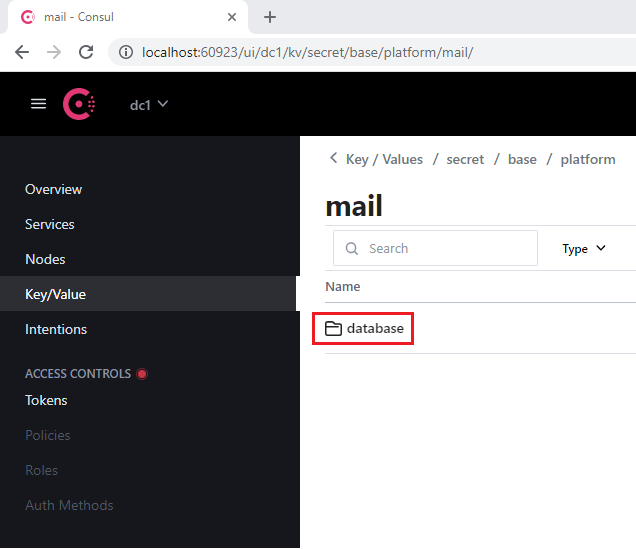

- Seleccione el proyecto platform o vantage, así como el servicio correspondiente que utiliza la base de datos (por ejemplo, mail).

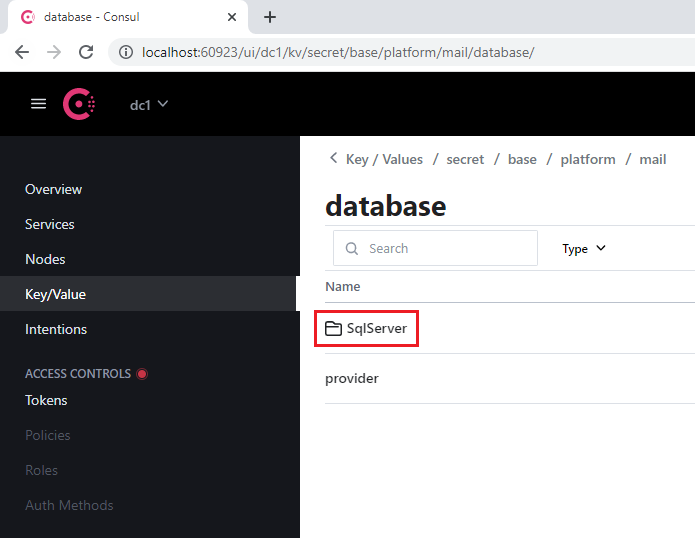

- Navegue a la sección database que incluye cada servicio.

- Abra la sección SqlServer.

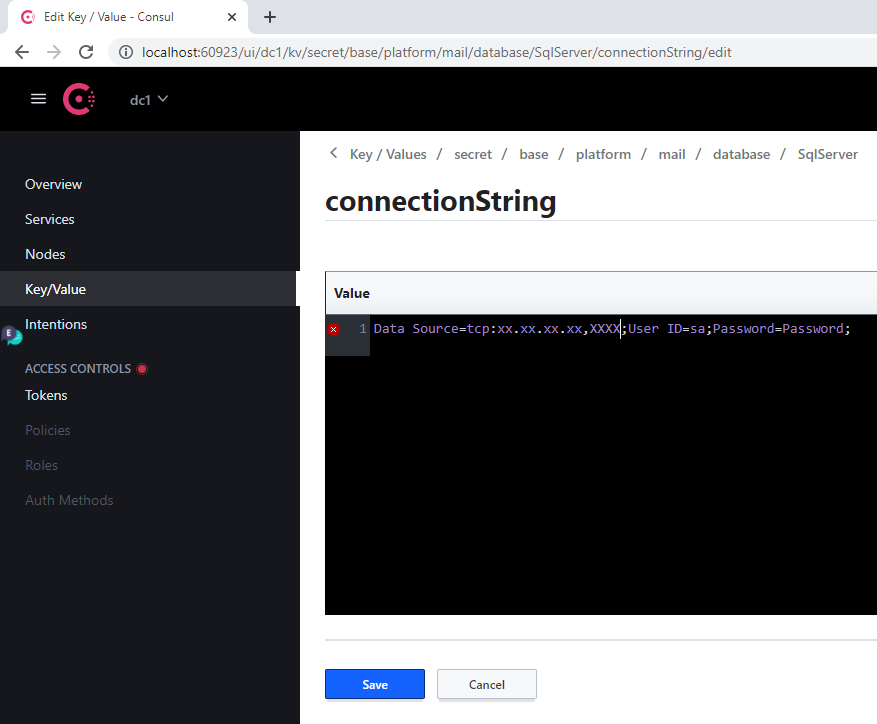

- En la clave connectionString:

- Reemplace el valor anterior de Server por la dirección del nuevo servidor

- Especifique la nueva base de datos en el parámetro Database

- Especifique las credenciales de acceso en los parámetros User Id y Password

- Haga clic en Save.

- Reinicie el servicio modificado ejecutando el siguiente comando:

Cuando cambie la dirección de un servidor, este procedimiento deberá ejecutarse para cada base de datos.

Referencia de servicios de base de datos

Servicios de plataforma

| Nombre de sección de Consul | Etiqueta de servicio | Notas |

|---|---|---|

| api-gateway-registry | api-gateway-registry | |

| api-registry | api-registry | |

| auth-adminapi2 | auth-adminapi2 | |

| auth-identity | auth-identity | |

| auth | auth-sts-identity, auth-adminapi2 | Esta base de datos la utilizan dos servicios |

| blob-storage | blob-storage | |

| cron-service | cron-service | |

| documentsetstorage | documentsetstorage | |

| security-audit | security-audit | |

| storage | storage | La sección de la base de datos se almacena en el catálogo de datos fileMetadata |

| workflow-facade | workflow-facade | |

| workflow-scheduler | workflow-scheduler |

Servicios de Vantage

| Nombre de la sección en Consul | Etiqueta del servicio |

|---|---|

| catalogstorage | catalogstorage |

| folderimport | folderimport |

| interactive-jobs | interactive-jobs |

| mailimport | mailimport |

| permissions | permissions |

| publicapi | publicapi |

| reporting | reporting |

| secretstorage | secretstorage |

| skill-monitor | skill-monitor |

| skillinfo | skillinfo |

| subscriptions | subscriptions |

| tokenmanagement | tokenmanagement |

| transactions | transactions |

| workspace | workspace |

Configuración de la GPU

Requisitos del sistema para la GPU

- RAM mínima de la GPU virtual: 12 GB

- 1 CPU y 4 GB de RAM para cada GPU virtual en el host (p. ej., una máquina virtual con una sola GPU virtual de 12 GB debe tener al menos 2 CPU y 8 GB de RAM)

GPU virtual

- Copie el paquete del controlador NVIDIA GRID desde el hub de aplicaciones de NVIDIA a una máquina virtual con GPU y ejecute los siguientes comandos:

-

Instale el operador de GPU de NVIDIA en el clúster de Kubernetes:

a. Coloque el archivo de token de licencia (generado en el hub de aplicaciones de NVIDIA) en la carpeta

$PWD/gpu/antes de ejecutar el contenedor del instalador de Vantage. b. Agregue el parámetro-v $PWD/gpu:/ansible/files/gpu:roal comando para ejecutar el contenedor del instalador de Vantage:

[abbyy_workers]. El nombre de la máquina virtual con la GPU debe contener “gpu”:

- Configura la vGPU ejecutando el siguiente playbook:

GPU Passthrough

- Ejecute el contenedor del instalador de Vantage:

- Añada un nodo GPU (por ejemplo, worker2-12-a40-gpu01) al archivo de inventario en el grupo

[abbyy_workers]:

- Ejecutar el playbook:

- Instale el chart de Helm del operador de GPU:

- Agregue un taint al nodo:

Pruebas y despliegue de GPU

- Ejecute el siguiente comando:

- Cree un archivo YAML con el siguiente contenido y aplíquelo:

- Consulta el registro del pod. Deberías ver una respuesta que contenga

Test PASSED:

- Añada los siguientes Parameter al archivo

env_specific.yml:

- Realice una de las siguientes acciones:

- Si Vantage ya está instalado, ejecute el siguiente playbook para desplegar workers de GPU:

- Si Vantage aún no está instalado, los GPU workers se desplegarán durante la instalación.

Configuración de un tiempo de espera por inactividad en la revisión manual

- Acceda a la interfaz web de Consul ejecutando:

http://localhost:8500/ui/dc1/kv/secret/.

- Use la pestaña Key/Value para seleccionar el entorno de Vantage correcto.

- Cambie los valores de las siguientes claves:

| Key | Description |

|---|---|

secret/abbyy-vantage/vantage/verification/interactiveJobsOptions/popTimeout | El período mínimo de tiempo que un usuario puede permanecer inactivo antes de que una tarea se devuelva a la cola de tareas interactivas. Cualquier acción interactiva (movimiento del ratón, entrada por teclado, procesamiento de parches, etc.) restablece la cuenta regresiva. Valor predeterminado: 00:15:00 (15 minutos) |

secret/abbyy-vantage/vantage/verification/interactiveJobsOptions/processingPopTimeout | El período mínimo de inactividad del usuario tras el cual la tarea se devolverá a la cola si hay operaciones de larga duración (aplicar una skill, pasar páginas, etc.). Cuando se inicia una operación de larga duración, este valor se establece en el período máximo permitido de inactividad. Cuando la operación se completa, el período de inactividad se restablece al valor de popTimeout. Valor predeterminado: 1.00:00:00 (24 horas) |

- Haga clic en Save.

- Reinicie los servicios verification y manualverification:

Actualización del certificado SSL

Uso de Lens

- Vaya a Config > Secrets y busque todos los secretos con el nombre

platform-wildcard. - Para cada secreto, busque la subsección Data, haga clic en el icono Show y actualice los valores:

- Introduzca el valor del nuevo certificado en el campo

tls.crt - Introduzca el valor de su clave en el campo

tls.key

- Introduzca el valor del nuevo certificado en el campo

El certificado y la clave deben ser archivos PEM con contenido codificado en ASCII base64 (PKCS#8). Deben comenzar con

-----BEGIN CERTIFICATE----- para el certificado y -----BEGIN PRIVATE KEY----- para la clave.- Haga clic en Save.

Uso de la línea de comandos de Linux

- Asegúrese de tener acceso al clúster de Kubernetes:

- Coloque el certificado y la clave en formato PEM en la carpeta actual:

cert.pem,key.pem.

- Ejecute los siguientes comandos: