Como administrador del sistema, tiene la tarea de supervisar ABBYY Vantage en todo momento, gestionarlo, detectar cualquier error que pueda producirse durante el procesamiento de documentos, así como las causas de dichos errores.

Puede supervisar ABBYY Vantage utilizando:

- Archivos de registro de Vantage

- El servicio Skill Monitor integrado, que recopila estadísticas sobre las skills de Vantage existentes y proporciona información detallada sobre las transacciones finalizadas y en curso. Este servicio también le permite obtener la información sobre eventos de transacciones que necesita el soporte técnico.

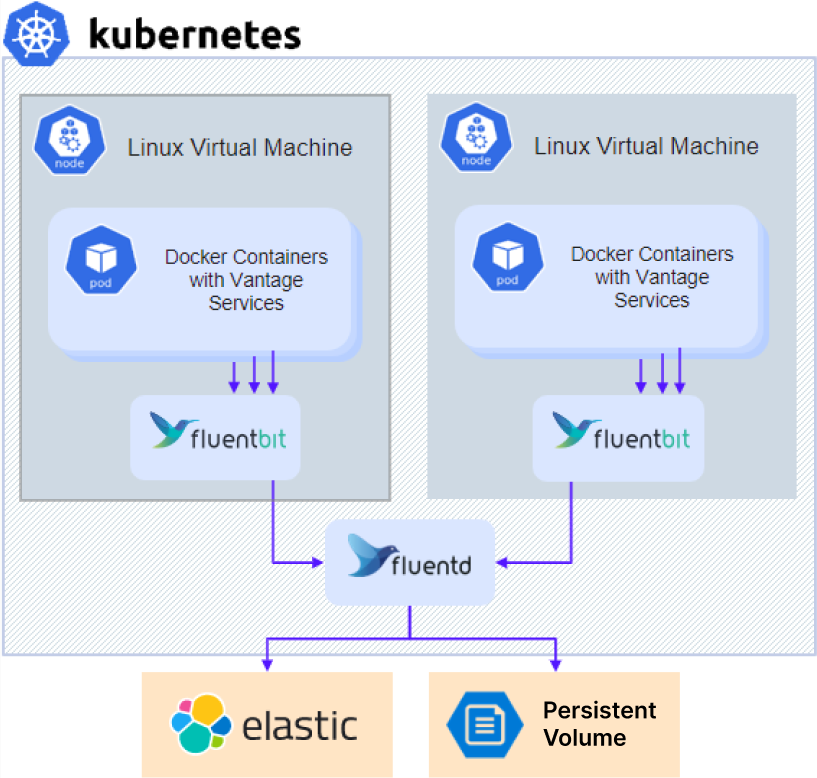

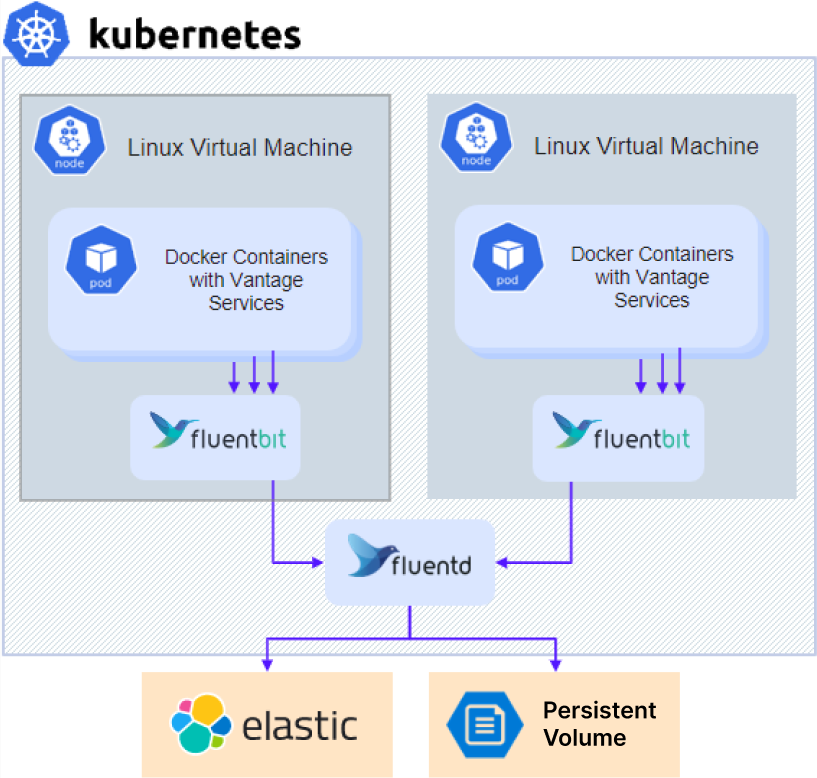

- Servicios de terceros que permiten supervisar los procesos internos de Vantage, supervisar flujos de trabajo específicos, analizar los datos recopilados para afinar y optimizar aún más el procesamiento de documentos, y recopilar y analizar registros.

Al ponerse en contacto con el soporte técnico, además de la información sobre los errores, también puede proporcionar la versión del producto y sus componentes haciendo lo siguiente:

- Haga clic en Help en el panel izquierdo, luego en About y seleccione Version details.

- Copie los detalles.

Cómo acceder a los registros de diagnóstico

Para acceder a los registros de diagnóstico:

Para acceder a los registros de diagnóstico:

- Si usa un servidor NFS externo u otro almacenamiento externo, vaya directamente al paso 3.

- Para una instalación con un servidor NFS dentro del clúster (valor predeterminado para la configuración Without high availability), obtenga la dirección IP del servidor NFS:

kubectl -n nfs get po -lapp.kubernetes.io/name=nfs-kernel-server -o jsonpath='{ .items[*].status.hostIP }'

- Acceda al recurso compartido:

- Para NFS:

- Linux:

mount –t nfs <nfs server ip>:/ /opt/mount

- Windows: Instale ClientForNFS, abra el Explorador de archivos y vaya a

\\<nfs server ip>

- Para otros tipos de almacenamiento externo: Póngase en contacto con su administrador de sistemas para obtener instrucciones de acceso.

- Vaya al directorio

\\<nfs server ip>\<sharename>\<env>\abbyy-monitoring\fluentd-pvc.

Proporcionar registros al soporte técnico

- Vaya a la carpeta de registros. Los registros se almacenan en subcarpetas que tienen los mismos nombres que los espacios de nombres (namespaces) del clúster de Kubernetes. Los registros de Vantage se encuentran en la carpeta

abbyy-vantage.

- Copie los archivos correspondientes al período de tiempo en el que se produjo el problema. Los registros se comprimen como archivos gzip cuyos nombres siguen el formato

Y-M-DD-H (por ejemplo, 2022-12-09-0800.log.gz).

- Envíe los archivos al soporte técnico de ABBYY.

Elasticsearch y Kibana son herramientas para buscar, analizar y visualizar registros. Elasticsearch y Kibana no se instalan junto con ABBYY Vantage y deben instalarse y configurarse por separado. Esto se puede hacer sin importar si el producto está instalado o no. Puede usar cualquier instalación existente.

El procedimiento de configuración de ejemplo que se muestra a continuación se ha simplificado y se proporciona solo como ejemplo.

- Clone el repositorio:

git clone https://github.com/elastic/cloud-on-k8s.git

cd cloud-on-k8s

git checkout 2.5

cd deploy/eck-operator

- Instale el operador que despliega los recursos:

helm -n elastic upgrade -i eck-operator . --create-namespace

- Cree un archivo llamado

elastic.yaml con el siguiente contenido:

apiVersion: elasticsearch.k8s.elastic.co/v1

kind: Elasticsearch

metadata:

name: elasticsearch

namespace: elastic

spec:

version: 8.5.1

nodeSets:

- config:

indices.fielddata.cache.size: 38%

xpack.ml.enabled: false

xpack.security.enabled: true

count: 1

name: default

podTemplate:

spec:

containers:

- name: elasticsearch

resources:

limits:

memory: 1Gi

cpu: '1'

requests:

cpu: '1'

memory: 1Gi

initContainers:

- command:

- sh

- '-c'

- sysctl -w vm.max_map_count=262144

name: sysctl

securityContext:

privileged: true

runAsUser: 0

nodeSelector:

kubernetes.io/os: linux

volumeClaimTemplates:

- metadata:

name: elasticsearch-data

spec:

accessModes:

- ReadWriteOnce

resources:

requests:

storage: 128Gi

- Cree un archivo llamado

kibana.yaml con el siguiente contenido:

apiVersion: kibana.k8s.elastic.co/v1

kind: Kibana

metadata:

name: kibana

namespace: elastic

spec:

version: 8.5.1

count: 1

elasticsearchRef:

name: elasticsearch

podTemplate:

spec:

containers:

- name: kibana

env:

- name: NODE_OPTIONS

value: "--max-old-space-size=2048"

resources:

requests:

memory: 512Mi

cpu: 0.5

limits:

memory: 1Gi

cpu: 1

nodeSelector:

kubernetes.io/os: linux

- Ejecute el siguiente comando para instalar Elasticsearch:

kubectl -n elastic apply -f elastic.yaml

kubectl -n elastic get statefulset

- Ejecute el siguiente comando para instalar Kibana:

kubectl -n elastic apply -f kibana.yaml

kubectl -n elastic get deployment

- Obtenga la contraseña de un usuario de Elasticsearch:

kubectl -n elastic get secret elasticsearch-es-elastic-user -o go-template='{{.data.elastic | base64decode }}'

- Añada los siguientes parámetros a su archivo

env_specific.yaml:

logging:

enabled: true

elasticsearch:

enabled: true

host: elasticsearch-es-http.elastic.svc.cluster.local

username: elastic

password: elastic_user_password

scheme: https

- Si va a instalar Kibana después de que el producto ya esté instalado, actualice su archivo

env_specific.yaml y ejecute el siguiente comando:

ansible-playbook -i inventories/k8s playbooks/6-DeployMonitoring-k8s.yml

Grafana debe instalarse en el clúster, ya que Prometheus solo está disponible dentro de un clúster.

El procedimiento de configuración de ejemplo que se muestra a continuación se ha simplificado y se proporciona únicamente a modo de ejemplo.

- Cree un archivo llamado

grafana.yaml.

- Copie y pegue el siguiente código en el archivo y guárdelo:

persistence:

enabled: false

rbac:

create: true

namespaced: false

serviceAccount:

create: true

podLabels:

app.kubernetes.io/component: grafana

nodeSelector:

kubernetes.io/os: linux

adminUser: admin

adminPassword: password

plugins:

- grafana-piechart-panel

- flant-statusmap-panel

grafana.ini:

server:

root_url: "%(protocol)s://%(domain)s:%(http_port)s/grafana/"

enable_gzip: "true"

ingress:

enabled: true

annotations:

kubernetes.io/ingress.class: abbyy-nginx

nginx.ingress.kubernetes.io/rewrite-target: /$2

tls:

- secretName: platform-wildcard

hosts:

- {{ env }}.{{ domain }}

hosts:

- {{ env }}.{{ domain }}

path: "/grafana(/|$)(.*)"

sidecar:

dashboards:

enabled: true

label: grafana_dashboard

datasources:

datasources.yaml:

apiVersion: 1

datasources:

- name: Prometheus

editable: true

isDefault: true

jsonData:

timeInterval: 5s

tlsSkipVerify: true

type: prometheus

url: 'http://prometheus-scaling.abbyy-monitoring.svc.cluster.local:9090'

- editable: true

isDefault: true

jsonData:

timeInterval: 5s

tlsSkipVerify: true

name: Victoria

type: prometheus

url: 'http://victoria-metrics-abbyy.abbyy-monitoring.svc.cluster.local:8428'

Reemplace el valor del parámetro host con el nombre de dominio de su clúster de Vantage y cambie la contraseña inicial del administrador.

- Ejecute los siguientes comandos:

helm repo add grafana https://grafana.github.io/helm-charts

helm -n abbyy-monitoring upgrade -i grafana grafana/grafana -f grafana.yaml