- Exécutez Windows PowerShell en tant qu’administrateur.

- Installez le client NFS de Windows :

- Configurez un mappage des utilisateurs Windows vers des UID et GID Unix conformément à la politique de votre entreprise :

- Redémarrer le client NFS :

Configuration d’une connexion à une base de données

Avant de commencer, assurez-vous que l’outil en ligne de commande kubectl est installé et qu’une connexion au cluster Kubernetes a été établie.

- Accédez à l’interface Web de Consul en exécutant la commande ci-dessous :

http://localhost:8500/ui/dc1/kv/secret/.

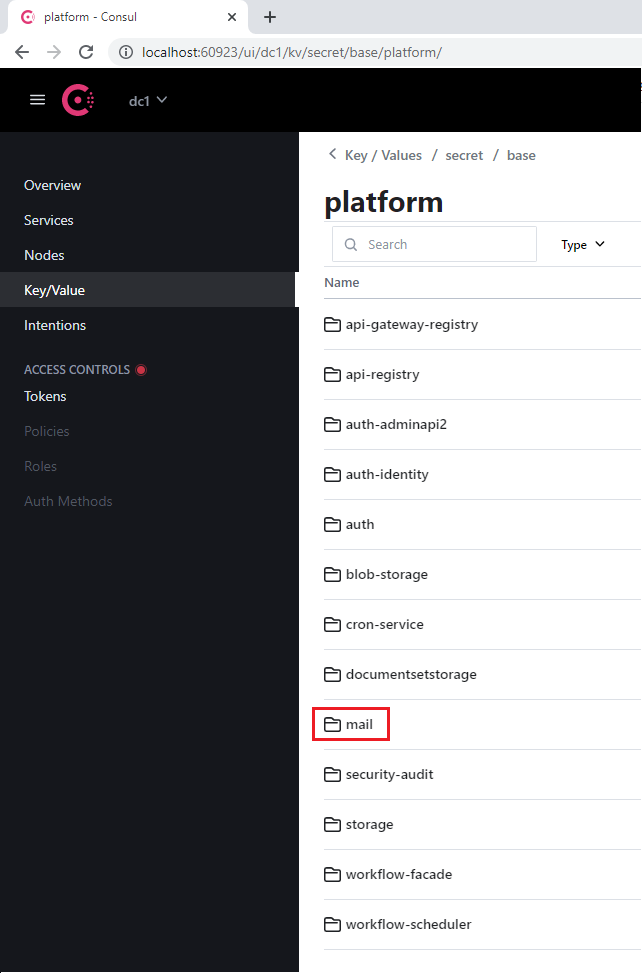

- Utilisez l’onglet Key/Value qui s’ouvre pour sélectionner l’environnement Vantage approprié.

- Sélectionnez le projet platform ou vantage, ainsi que le service approprié qui utilise la base de données (par exemple, mail).

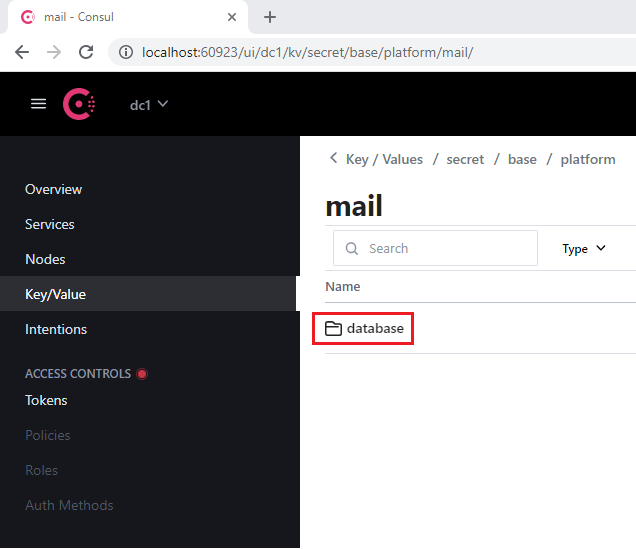

- Accédez à la section database présente dans chaque service.

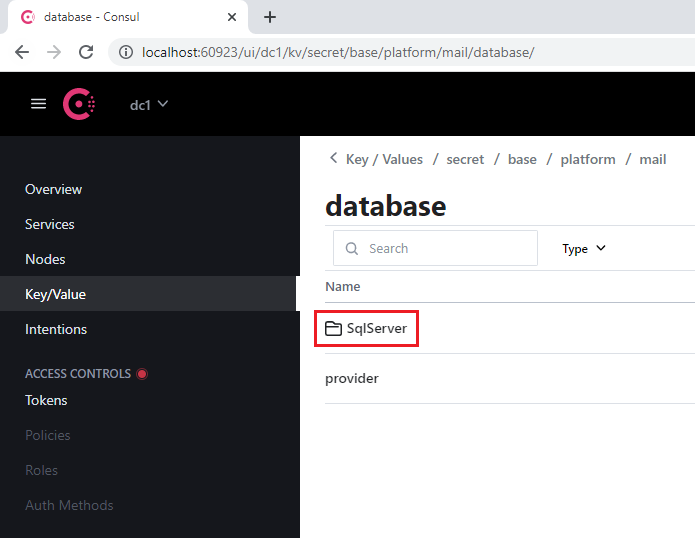

- Ouvrez la section SqlServer.

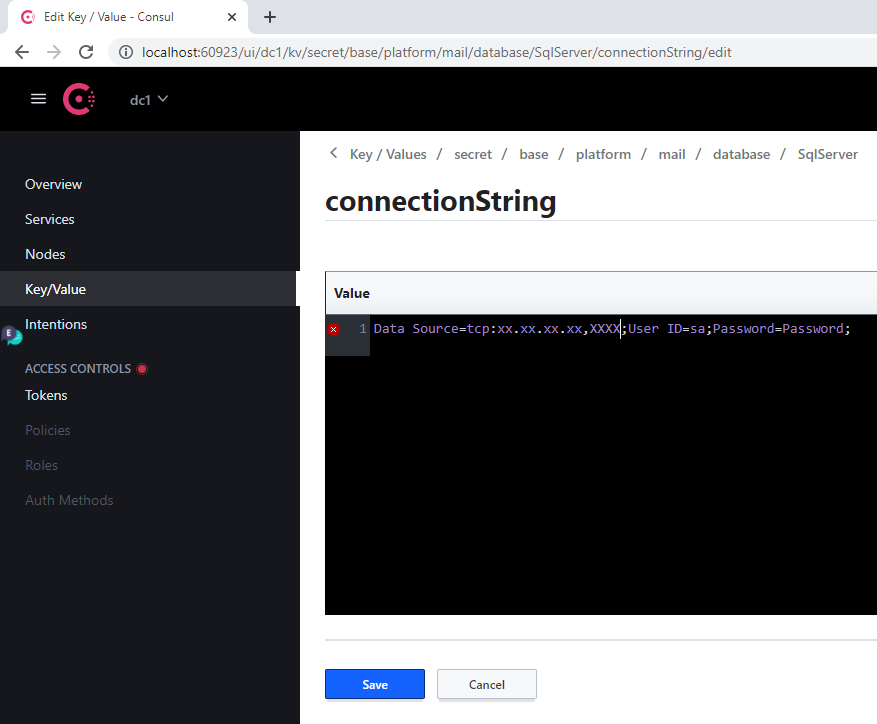

- Dans la clé connectionString :

- Remplacez l’ancienne valeur de Server par l’adresse du nouveau serveur

- Indiquez la nouvelle base de données dans le paramètre Database

- Indiquez les identifiants de connexion dans les paramètres User Id et Password

- Cliquez sur Save.

- Redémarrez le service modifié en exécutant la commande suivante :

Lorsqu’une adresse de serveur est modifiée, cette procédure doit être effectuée pour chaque base de données.

Référence des services de base de données

Services de plateforme

| Nom de section Consul | Libellé du service | Remarques |

|---|---|---|

| api-gateway-registry | api-gateway-registry | |

| api-registry | api-registry | |

| auth-adminapi2 | auth-adminapi2 | |

| auth-identity | auth-identity | |

| auth | auth-sts-identity, auth-adminapi2 | Cette base de données est utilisée par deux services. |

| blob-storage | blob-storage | |

| cron-service | cron-service | |

| documentsetstorage | documentsetstorage | |

| security-audit | security-audit | |

| storage | storage | La section de base de données est stockée dans le catalogue de données fileMetadata. |

| workflow-facade | workflow-facade | |

| workflow-scheduler | workflow-scheduler |

Services Vantage

| Nom de la section Consul | Libellé du service |

|---|---|

| catalogstorage | catalogstorage |

| folderimport | folderimport |

| interactive-jobs | interactive-jobs |

| mailimport | mailimport |

| permissions | permissions |

| publicapi | publicapi |

| reporting | reporting |

| secretstorage | secretstorage |

| skill-monitor | skill-monitor |

| skillinfo | skillinfo |

| subscriptions | subscriptions |

| tokenmanagement | tokenmanagement |

| transactions | transactions |

| workspace | workspace |

Configuration du GPU

Configuration système requise pour le GPU

- Mémoire GPU virtuelle minimale : 12 Go

- 1 CPU et 4 Go de RAM pour chaque GPU virtuel sur l’hôte (par exemple, une VM avec un seul GPU virtuel de 12 Go doit disposer d’au moins 2 CPU et 8 Go de RAM)

GPU virtuel

- Copiez le package de pilotes NVIDIA GRID depuis le hub d’applications NVIDIA vers une machine virtuelle équipée d’un GPU et exécutez les commandes suivantes :

-

Installez l’opérateur GPU NVIDIA sur le cluster Kubernetes :

a. Placez le fichier de jeton de licence (généré dans le NVIDIA Application Hub) dans le dossier

$PWD/gpu/avant d’exécuter le conteneur d’installation de Vantage. b. Ajoutez le Parameter-v $PWD/gpu:/ansible/files/gpu:roà la commande utilisée pour exécuter le conteneur d’installation de Vantage :

[abbyy_workers]. Le nom de la machine virtuelle équipée d’un GPU doit contenir “gpu” :

- Configurez la vGPU en exécutant le playbook suivant :

GPU passthrough

- Exécutez le conteneur d’installation de Vantage :

- Ajoutez un nœud GPU (par exemple worker2-12-a40-gpu01) au fichier d’inventaire dans le groupe

[abbyy_workers]:

- Exécutez le playbook :

- Installez le chart Helm de l’opérateur GPU :

- Ajoutez un taint de nœud :

Test et déploiement de GPU

- Exécutez la commande suivante :

- Créez un fichier YAML avec le contenu suivant, puis appliquez-le :

- Vérifiez les logs du pod. Vous devriez voir une réponse contenant

Test PASSED:

- Ajoutez les paramètres suivants dans le fichier

env_specific.yml:

- Effectuez l’une des opérations suivantes :

- Si Vantage est déjà installé, exécutez le playbook suivant pour déployer des workers GPU :

- Si Vantage n’est pas encore installé, les workers GPU seront déployés au cours de l’installation.

Configuration d’un délai d’inactivité pour la relecture manuelle

- Accédez à l’interface web de Consul en exécutant :

http://localhost:8500/ui/dc1/kv/secret/.

- Utilisez l’onglet Key/Value pour sélectionner l’environnement Vantage approprié.

- Modifiez les valeurs des clés suivantes :

| Key | Description |

|---|---|

secret/abbyy-vantage/vantage/verification/interactiveJobsOptions/popTimeout | Période minimale d’inactivité d’un utilisateur avant qu’une tâche ne soit renvoyée dans la file d’attente des tâches interactives. Toute action interactive (déplacement de la souris, saisie au clavier, traitement de patch, etc.) réinitialise le compte à rebours. Par défaut : 00:15:00 (15 minutes) |

secret/abbyy-vantage/vantage/verification/interactiveJobsOptions/processingPopTimeout | Période minimale d’inactivité d’un utilisateur après laquelle la tâche sera renvoyée dans la file d’attente s’il y a des opérations de longue durée (application d’une compétence, changement de page, etc.). Lorsqu’une opération de longue durée démarre, cette valeur est définie sur la période d’inactivité maximale autorisée. Lorsque l’opération est terminée, la période d’inactivité est réinitialisée à la valeur popTimeout. Par défaut : 1.00:00:00 (24 heures) |

- Cliquez sur Save.

- Redémarrez les services verification et manualverification :

Mise à jour du certificat SSL

Utilisation de Lens

- Accédez à Config > Secrets et repérez tous les secrets nommés

platform-wildcard. - Pour chaque secret, ouvrez la sous-section Data, cliquez sur l’icône Show, puis mettez à jour les valeurs :

- Saisissez la valeur du nouveau certificat dans le champ

tls.crt - Saisissez la valeur de sa clé dans le champ

tls.key

- Saisissez la valeur du nouveau certificat dans le champ

Le certificat et la clé doivent être des fichiers PEM dont le contenu est encodé en ASCII base64 (PKCS#8). Ils doivent commencer par

-----BEGIN CERTIFICATE----- pour le certificat et -----BEGIN PRIVATE KEY----- pour la clé.- Cliquez sur Save.

Utiliser la ligne de commande Linux

- Assurez-vous d’avoir accès au cluster Kubernetes :

- Placez le certificat et la clé au format PEM dans le répertoire courant :

cert.pem,key.pem.

- Exécutez les commandes suivantes :